Предыдущие вызовы нейронной сети ( то и это ) вдохновили меня поставить новую задачу:

Соревнование

Найдите наименьшую нейронную сеть с прямой связью, такую, что для любого 4-мерного входного вектора с целочисленными значениями в сеть выводит с координатной ошибкой, строго меньшей, чем .

допустимость

Для этой задачи нейронная сеть с прямой связью определяется как композиция слоев . Слой является функцией , что определяется матрицей из веса , вектор из уклонов , а функция активации , который применяется покоординатным:

Поскольку функции активации могут быть настроены для любой конкретной задачи, нам нужно ограничить класс функций активации, чтобы эта задача была интересной. Разрешены следующие функции активации:

Идентичность.

РЕЛУ.

Softplus.

Гиперболический тангенс.

Сигмовидной.

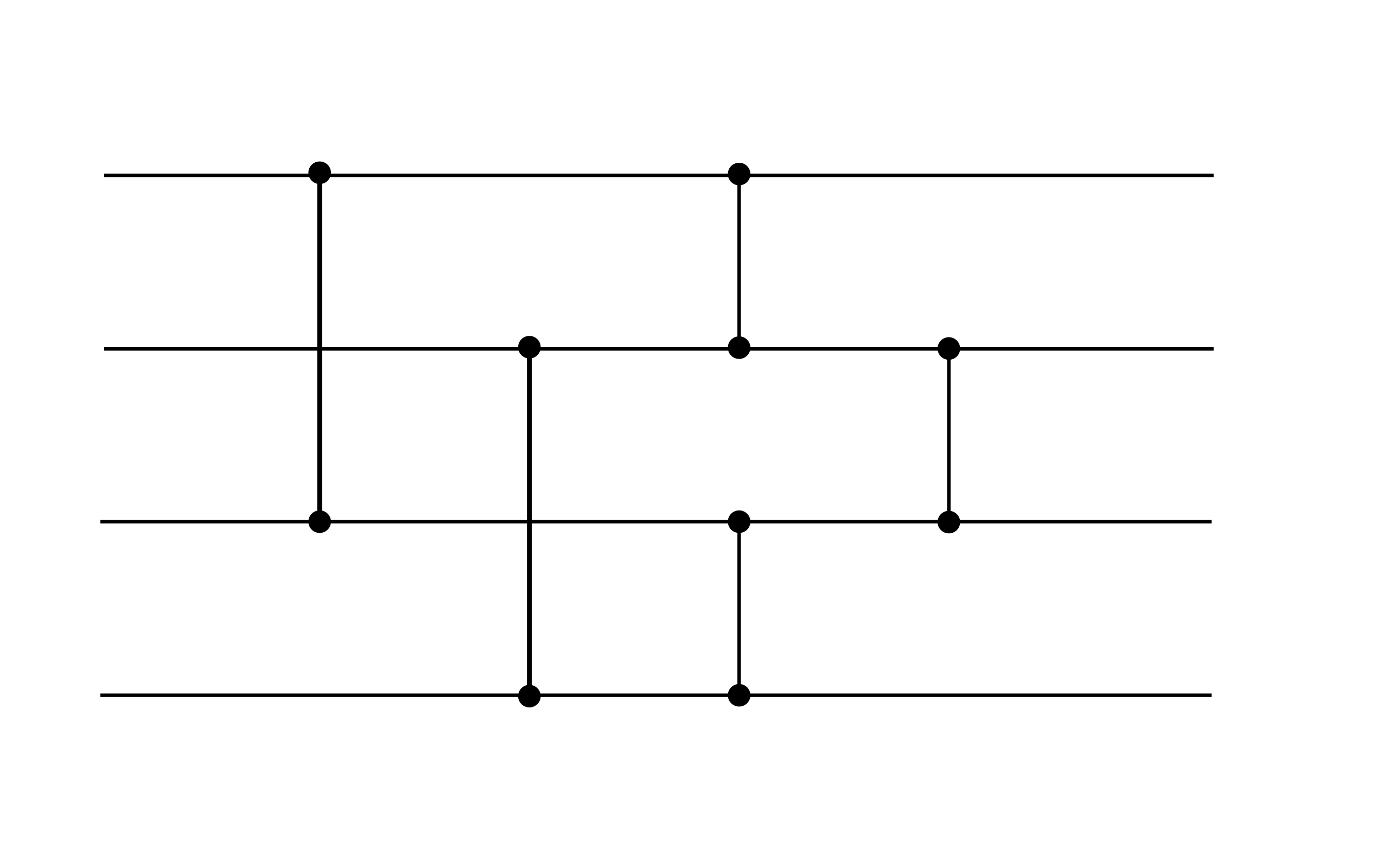

В целом, допустимая нейронная сеть принимает форму для некоторого , где каждый слой определяется весами , смещениями и функцией активации из приведенного выше списка. Например, допустима следующая нейронная сеть (хотя она не удовлетворяет цели производительности этой задачи, это может быть полезным гаджетом):

Этот пример демонстрирует два слоя. Оба слоя имеют нулевое смещение. Первый уровень использует активацию ReLU, а второй использует идентификацию активации.

счет

Ваша оценка - это общее количество ненулевых весов и смещений.

(Например, приведенный выше пример имеет оценку 16, поскольку векторы смещения равны нулю.)